Zalecam ostrożność #2: Przejmowanie sztuki cyfrowej pod pretekstem jej uwolnienia. Rozważania o niekorzyściach AI art.

Wyrażanie się poprzez twórczość artystyczną, to bardzo *ludzka rzecz. Jednym z przejawów takiej twórczości są sztuki plastyczne. W każdym okresie historycznym dowolna grupa społeczna, z dowolnej szerokości geograficznej, mogła pochwalić się swoimi wytworami sztuki, jak i swoimi artystami. Już w paleolicie górnym powstawały jaskiniowe malowidła, z których najstarsze nam znane pochodzi sprzed 40 tysięcy lat. Chociaż jednoznaczne sformułowanie definicji „sztuki” jest trudne, a jej znaczenie zmienia się w różnych kontekstach, to wspólnym mianownikiem jest człowiek, który w ramach twórczego procesu sztukę tworzy. Tak przynajmniej było do lat 60. XX, w których zaczęły pojawiać się pierwsze eksperymentalne działania związane z tzw. sztuką generatywną – tworzoną przez systemy autonomiczne. Wykładniczy rozwój technologii cyfrowych sprawił, że i w obszarze generowania obrazów przez algorytmy możliwe było coraz więcej. Rozkwit popularności systemów generujących tzw. AI art, w szczególności modele text-to-image, obserwowalny w ostatnich kilku latach, każe zastanowić się nad aktualnością i pojemnością pojęcia „sztuka”. Jednak tym razem, wyraźniej niż kiedykolwiek wcześniej, pojawiają się pytania o rolę artystów, ich sens bycia, jak również o istotę i istotność procesów twórczych. Czy nowe systemy cyfrowe pozwolą każdemu zostać twórcą, a twórczy proces uproszczą do prostego „prompta”? Czy może bezpowrotnie pozbywamy się z naszej kultury kolejnego pierwiastka człowieczeństwa, przekazując władzę nad tworzeniem obrazów sieciom neuronowym, zarządzanym przez prywatne firmy z Doliny Krzemowej i Shenzhen?

Niniejszy tekst jest drugim z serii „Zalecam ostrożność”, w ramach której krytycznie przyglądam się tzw. generatywnym AI. W poprzednim tekście opisałem zasadę działania Dużych Modeli Językowych (Large Language Models) takich jak ChatGPT oraz przedstawiłem problem „pozornej spójności”, który wpływa na to jak ludzie postrzegają odpowiedzi generowane przez maszynę. Dzisiaj zdecydowałem się omówić temat generowania obrazów przez sieci neuronowe.

Namaluj mi psa patrzącego nocą w gwiazdy

Jeżeli korzystaliście z Midjourney, DALL-E 2, Stable Diffusion, czy innych systemów do generowania obrazów na podstawie opisu tekstowego (text-to-image), to być może podobnie jak u mnie za pierwszym razem, pojawiła się u Was mieszanka ekscytacji, zadziwienia i niepokoju, a wraz z nimi pytanie „Jak to jest możliwe?”.

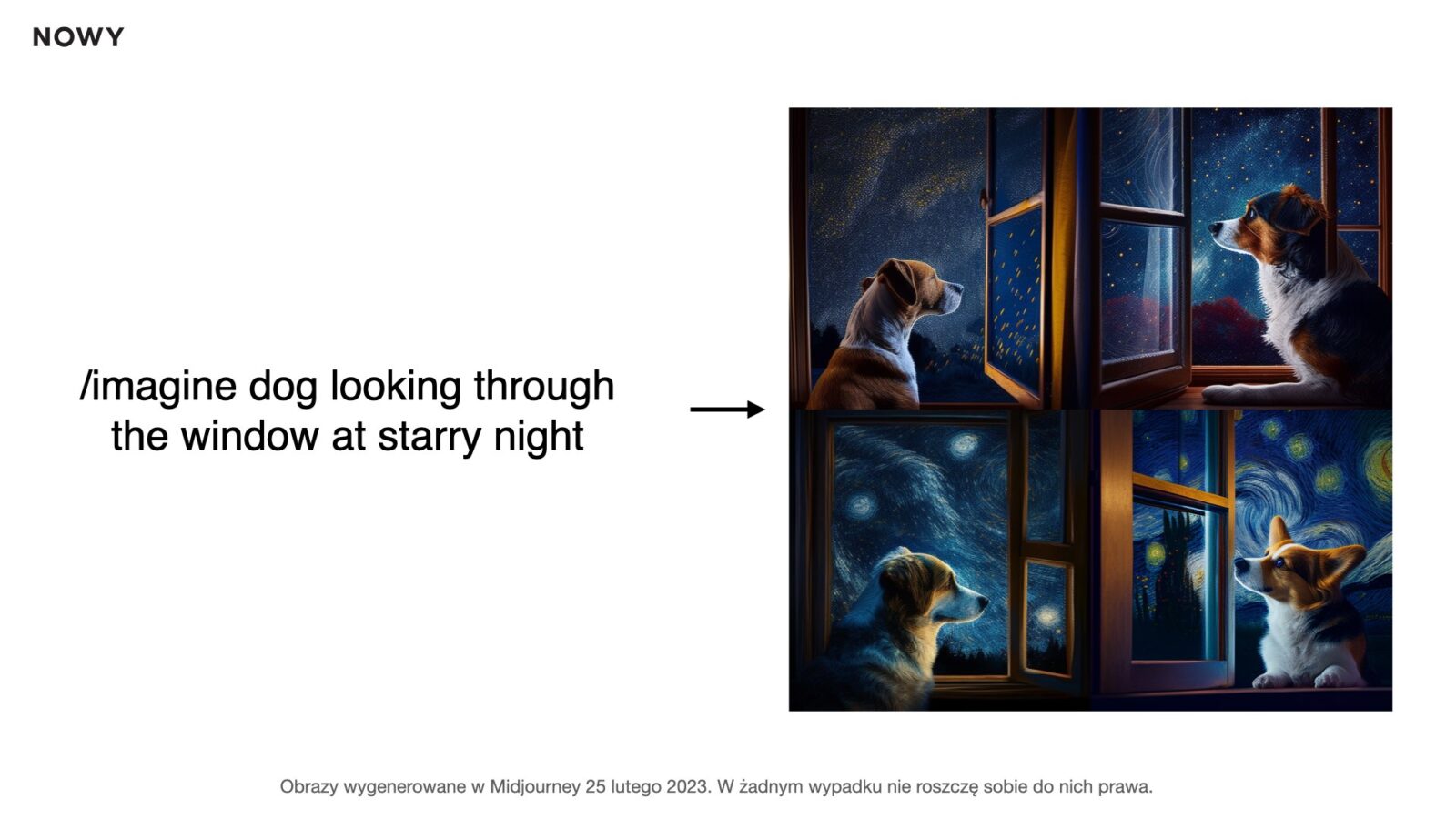

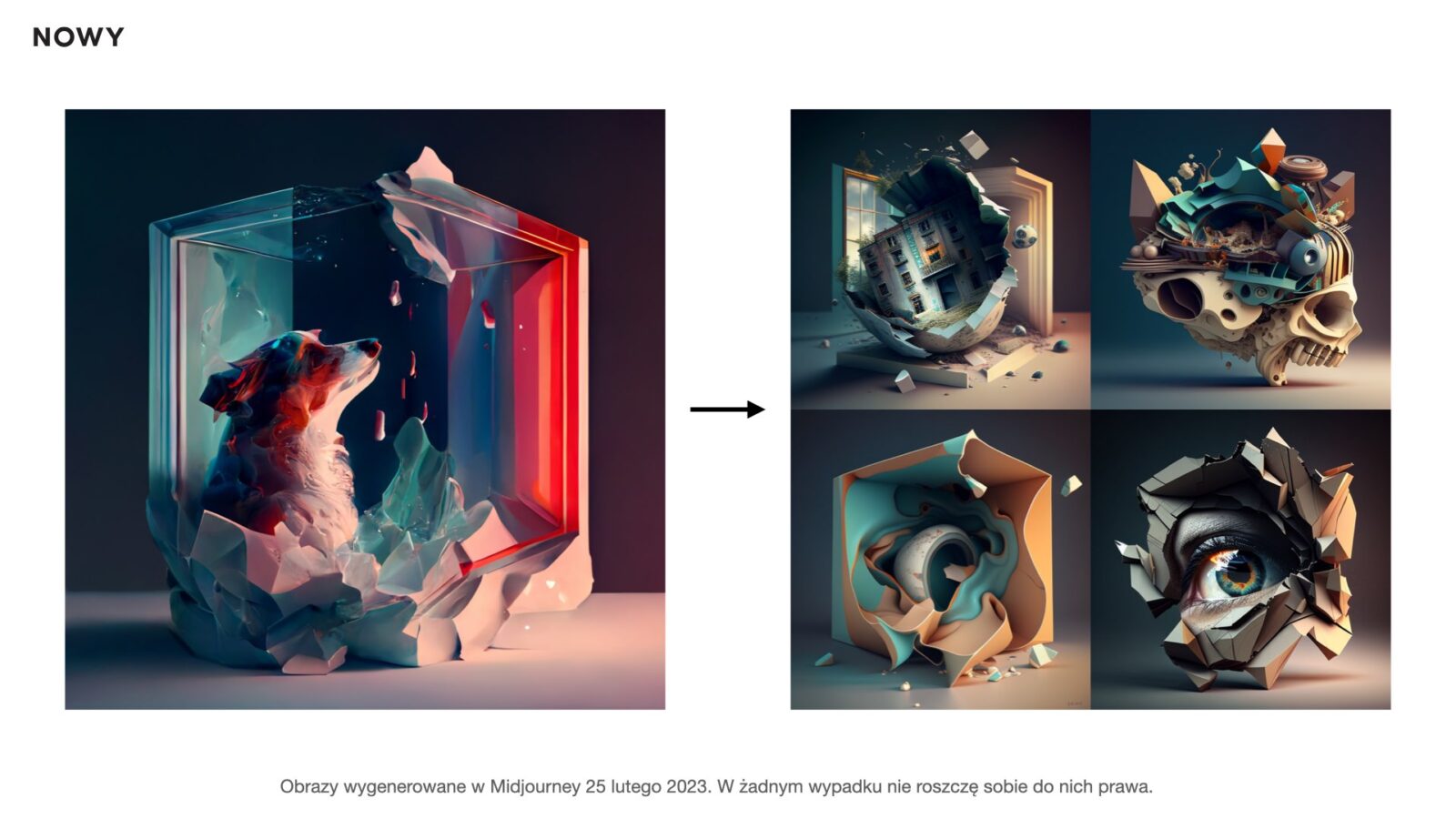

Zrobiłem taki eksperyment. Zalogowałem się do Midjourney i wpisałem frazę „Pies patrzący przez okno w gwieździstą noc” i po kilkudziesięciu sekundach uzyskałem poniższe cztery rysunki.

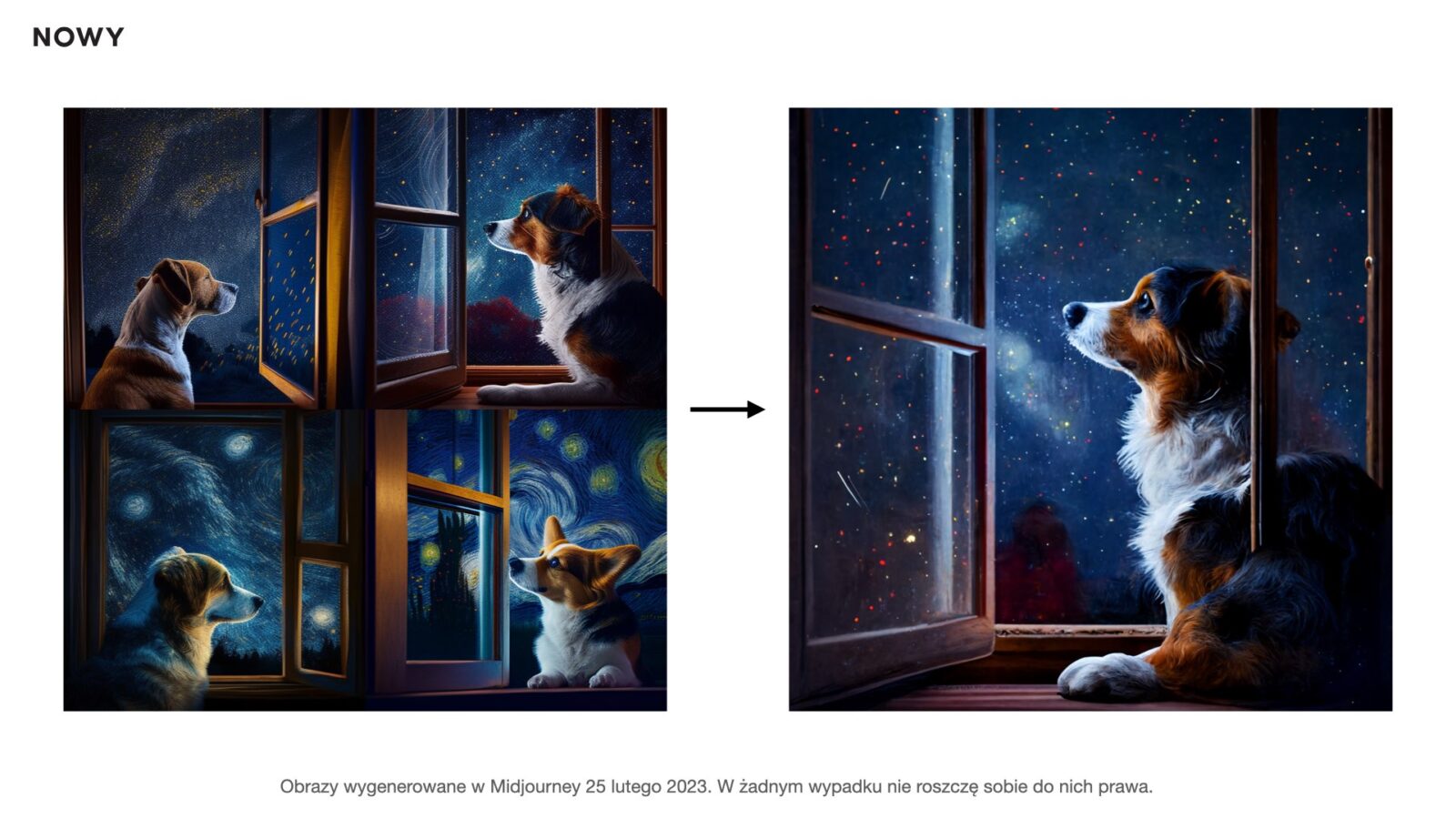

Następnie poprosiłem o wyskalowanie drugiego z nich. Kilkadziesiąt kolejnych sekund minęło i otrzymałem psa, który dosyć dziwnie siedzi, nie odbija się w szybie, i ma na sobie kawałek okna. Nie miało to jednak dla mnie dużego znaczenia, bo to przecież eksperyment, więc takie błędy dodają tylko dodatkowych informacji pokazując dzisiejsze niedoskonałości tego systemu.

Zdecydowałem, że zostawię te niedociągnięcia. W kolejnym kroku poprosiłem o wykonanie propozycji tego obrazu, ale w wersji 3D. Użyłem w zapytaniu linka do uprzednio wygenerowanego obrazu dodając słowa „is 3D”. Program przetworzył to, co rozpoznał na rysunku i połączył to z moją prośbą o uczynienie rysunku trójwymiarową wizualizacją. Otrzymałem poniższe 4 propozycje, które były dosyć dziwne i mieszały wątki psa i gwieździstego nieba, ale pojawiły się w nich motywy, których nie rozumiałem.

Z zaproponowanych wybrałem rysunek trzeci, który był najbliższy mojej początkowej idei, ale ze smutkiem stwierdziłem brak oczu u mojego pieska. Brak oczu, dziwne uszy, czy nadmiarowa liczba zębów i palców, to wynik powszechnie znanych niedoskonałości generatorów text-to-image, które z pewnością zostaną z czasem wyeliminowane. Programy te nie „wiedzą” jeszcze, że brak oczu to problem, bo „uznają”, że statystycznie wszystko w wygenerowanej przez nie abstrakcji jest w porządku.

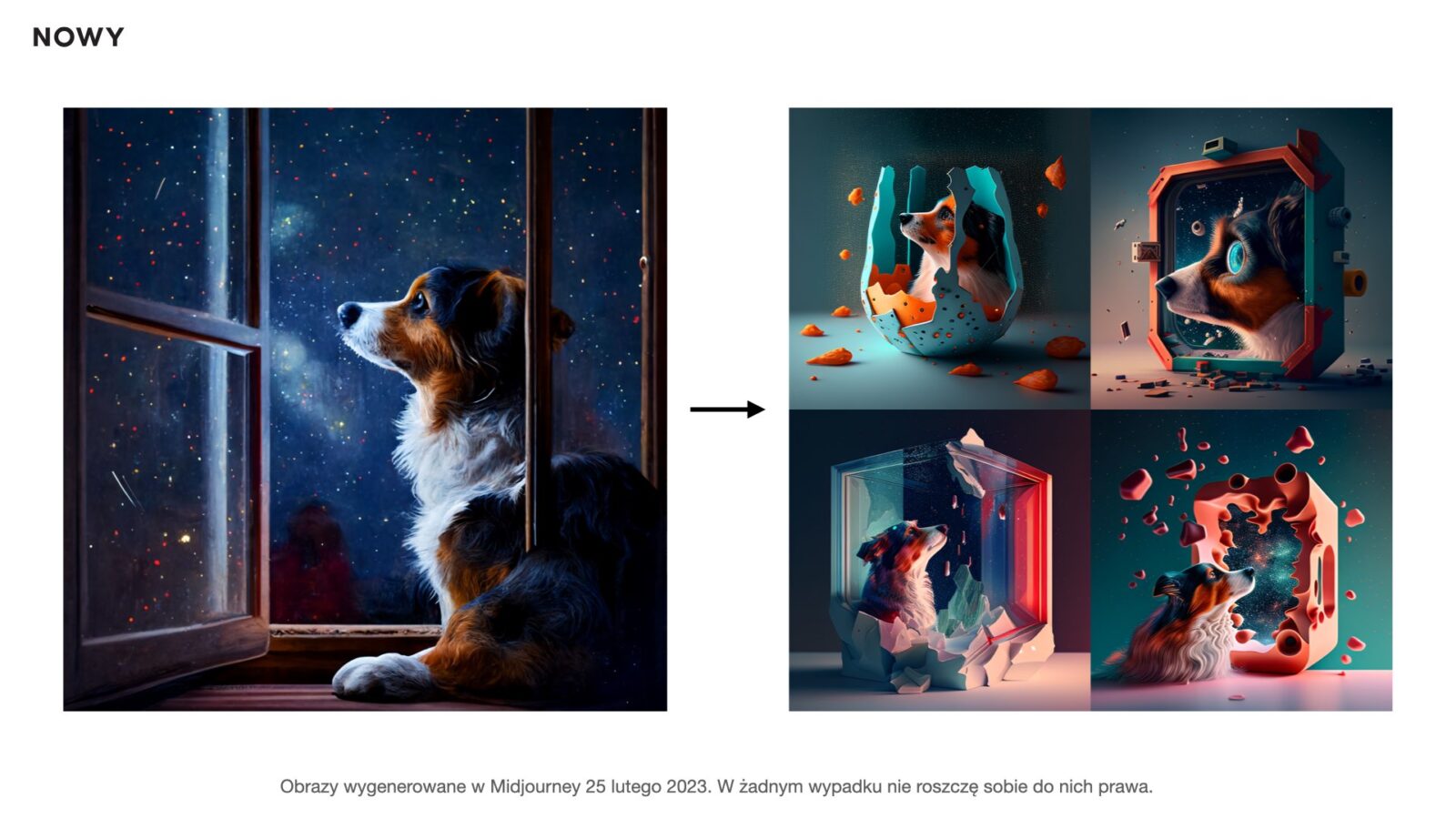

Wizualizacja psa bez oczu posłużyła mi jako prompt do wygenerowania jeszcze czterech wariantów. W rezultacie otrzymałem niezrozumiałe dla mnie rysunki, nie mające zbyt wiele wspólnego z psem wyglądającym przez okno w gwieździstą noc. Były jednak ciekawym tropem w mojej analizie działania programu.

Wyłączyłem Midjourney, bo nie chciałem poświęcać więcej czasu na dopracowanie projektu (i jednoczesne trenowanie modelu), mimo, że ten proces był niepokojąco wciągający. Cała zabawa trwała kilka minut.

Wyłanianie z szumu

W Intenecie znajduje się całkiem sporo dobrze opracowanych artykułów naukowych i popularnonaukowych tłumaczących zasady działania Midjourney oraz innych modeli text-to-image, dlatego nie będę wchodzić we wszystkie szczegóły. W dużym uproszczeniu przybliżę na poziomie koncepcyjnym proces generowania obrazów. Wszystkich zainteresowanych pogłębieniem tego zagadnienia odsyłam tutaj, tutaj, tutaj i tutaj.

Dodam, że pełne zrozumienie zasad działania tak złożonych programów wymaga wiedzy w obszarze uczenia głębokiego (ang. deep learning), wizji komputerowej (ang. computer vision) i przetwarzania języka naturalnego (ang. natural language processing – NLP). Wierzę, że poniższy opis jest wystarczający, żeby zbudować kontekst dla dalszej części artykułu.

W pierwszym kroku moja „podpowiedź” – prompt o psie patrzącym nocą przez okno w gwiazdy – trafiła do kodera tekstu (ang. text encoder), który jest wytrenowany do tego, aby mapować słowa na obrazy (w semantyce zrozumiałej przez program). Na tym etapie mamy do czynienia z pierwszym modelem, uprzednio wytrenowanym na kilku miliardach obrazów i powiązanych z nimi opisów. W ramach treningu sieć neuronowa nauczyła się rozpoznawać, na ile dany fragment tekstu może odnosić się do konkretnego obiektu – zamiast próbować przewidzieć opis na podstawie obrazu, uczy się, w jaki sposób dany opis powiązać z obrazem. W ten sposób program poznaje znaczeniowy związek między tekstowymi opisami i wizualnymi reprezentacjami (np. łączy słowo „pies” z obrazem psa).

W kolejnym kroku Midjourney tworzy wielowymiarową przestrzeń utajoną (ang. latent space), mającą kilkaset wymiarów (ludzie widzą w trzech wymiarach), w której „układa” wizualne reprezentacje mojego tekstu (oczywiście w zrozumiałej dla siebie formie matematycznej, a nie wizualnej), szukając pomiędzy nimi zależności w oparciu o wartości zmiennych, które model tworzył i przypisywał w procesie głębokiego uczenia na danych treningowych. Jakie są to zmienne, jakie są ich wartości i zależności, nie jest wiadome nawet dla twórców modelu. Z perspektywy programu mają sens, ale niekoniecznie muszą być zrozumiałe i sensowne dla człowieka. Wielu z nich pewnie nie bylibyśmy w stanie nawet nazwać. Jednak w efekcie tego procesu w wielowymiarowej przestrzeni powstają klastry informacji, które definiują esencję tego, co program uznał za charakterystyczne i istotne do opisu psa, okna, gwiazd, nocy, patrzenia, patrzącego psa, okna w nocy, psa patrzącego na gwiazdy, psa patrzącego przez okno, kompozycji obrazu, stylu graficznego, etc.

Każdy punkt w tej wielowymiarowej przestrzeni jest potencjalnym obrazem, który może powstać w odpowiedzi na mój prompt – program wybiera punkt, który będzie „jego zdaniem” z największym prawdopodobieństwem odpowiadał moim oczekiwaniom (w przypadku Midjourney w pierwszej chwili były to 4 punkty, bo powstały 4 obrazy).

W ostatnim kroku program przekłada matematyczny zapis na obraz. Stosuje do tego tzw. dyfuzję. Modele dyfuzyjne to modele generatywne, co oznacza, że używane są do generowania danych podobnych do danych, na których są szkolone. Podobnie jak w przypadku ChatGPT, o czym pisałem ostatnio, model stara się ocenić prawdopodobieństwo najlepszej odpowiedzi w oparciu o to, czego nauczył się wcześniej. Nie uczy się jednak poprzez usuwanie słów z tekstu, jak model językowy, tylko trenowany jest na zasadzie niszczenia danych treningowych (obrazów) poprzez kolejne dodawanie szumu gaussowskiego, a następnie uczy się odzyskiwać te dane poprzez odwrócenie procesu „zaszumiania” – dostaje szum na wejściu i stara się odkryć, jaki obraz był na początku. Po takim treningu może zostać użyty do generowania nowych danych, przepuszczając losowo próbkowany szum przez wyuczony proces „odszumiania”.

Innymi słowy, model na wejściu dostaje z naszej wielowymiarowej przestrzeni dane, zamienione na szum, a następnie w wielu iteracjach „odszumiania” ukazują się piksele, a potem obraz, który z perspektywy człowieka ma sens (z określonym przez program prawdopodobieństwem).

Program, ze względu na działanie w oparciu o modele stochastyczne, naukę na miliardach obrazów, budowanie wielowymiarowych przestrzeni utajonych, które tylko on „rozumie”, nigdy nie wygeneruje dwóch takich samych obrazów, nawet dla tego samego zapytania.

Tak na marginesie. Niezrozumiałe dla mnie ostatnie cztery abstrakcyjne wizualizacje 3D, to przykłady grafik, będących wynikiem działania programu, który na wejściu otrzymał obraz i trochę treści. W tym przypadku nie było już kontekstu prompta słownego, tylko coś co można by nazwać image&text-to-image. Z tego wynika, że program biorąc psa patrzącego w gwiazdy w wersji 2D, a potem robiąc jego pierwsze warianty 3D sam dokonał rozpoznania treści obrazu i w ten sposób zbudował sobie prompt, doprowadzając w jednej z kolejnych iteracji do tych abstrakcji. Koncepcja psa i gwiazd w tym prompcie mogły mieć dużo mniejsze znaczenie, niż inne charakterystyki, które wybrał program.

Chylę czoło przed geniuszem twórców i ich sprawnością inżynierską, bowiem z perspektywy inżynieryjnej jest to rozwiązanie niezwykłe i fascynujące. Pociąga jednak za sobą szereg konsekwencji oraz zmusza do zadania kilku istotnych pytań.

Tworzenie vs. generowanie

Postawię tezę, że ludzie obrazy tworzą w procesie, a modele generatywne je generują i pomiędzy tworzeniem, a generowaniem nie ma znaku równości.

Ludzki proces twórczy opiera się na łączeniu intuicji i kompetencji (rozumianej jako wypadkowa wiedzy, umiejętności, postawy, doświadczenia, gotowości do działania).

Na tworzony obraz mogą wpływać m.in. zewnętrzni interesariusze (np. klienci zamawiający obraz), sytuacja zewnętrzna (np. wojna), popularny w danym okresie nurt (np. symbolizm).

W bardzo dużej mierze na ten proces wpływa wewnętrzny świat autora/autorki – nastrój w danej chwili, odczuwane emocje wyrażane w procesie tworzenia, ulubiony styl, wyrobiony przez lata praktyki.

Do tego należy dodać czas na... myślenie, przygotowanie koncepcji, szkice, wybór stylu i technik wykonawczych, znowu na myślenie, na działanie, przerywane myśleniem i czuciem, poszukiwaniem inspiracji, wprowadzaniem szeregu poprawek. To proces, w ramach którego twórcy przeżywają całe spektrum emocji, by wymienić kilka: złość, radość, miłość, nadzieja czy zwątpienie. Zwieńczeniem tego niejasnego i trudnego w opisie miksu może być obraz.

W przypadku modelu generatywnego wpisanie promptu skutkuje wyłonieniem się obrazu z szumu, w procesie który przybliżyłem wcześniej. Obraz nie powstaje dzięki latami rozwijanymi przez artystkę / artystę kompetencjom, pomysłowości i wrażliwości, tylko poprzez słowa wrzucone na sieci neuronowe nakarmione miliardami obrazów i zdjęć. Nasz każdy kolejny prompt to trening dla generatora, a olbrzymie moce obliczeniowe maszyn, na których wykonywany jest program, sprawiają, że czas generowania obrazu jest pomijalny, w porównaniu do tworzenie obrazu przez człowieka.

Co jednak, gdy mimo istotnych różnic pomiędzy procesem twórczym, a syntetycznym generowaniem obrazu, na końcu nie widać różnicy jakościowej, a w wielu przypadkach efekt może być uznany za lepszy? Czy ważniejsza jest droga, czy cel? Jeżeli w efekcie „darmowego” użycia generatora powstaje obraz, za który nie trzeba płacić, to w czym problem?

No właśnie, w czym problem?

Zdaję sobie sprawę, droga czytelniczko i drogi czytelniku, że w tym momencie możecie uznać, że romantyzuję proces twórczy i przeciwstawić mojej tezie m.in. następujące argumenty:

- Fotografia kiedyś była wskazywana jako zagrożenie dla malarstwa, a jednak malarstwo przetrwało.

- Prasy drukarskiej też się obawiali!

- Jest wiele osób, które nie mają „talentu” i teraz mogą się wyrażać poprzez sztukę, bez proszenia innych o pomoc.

- Sztuka generatywna ma swoje początki w połowie ubiegłego wieku, więc obserwujemy tylko jej akcelerację. Teraz jest bardziej powszechna i skuteczniejsza.

- Algorytmy od lat wykorzystywane są w narzędziach cyfrowych dla twórców, aby ułatwiać im pracę.

- Od ludzi zależy, co z tym zrobią, bowiem jest duża grupa kreatywnych, którzy chcą korzystać z AI art i nawet to robią z powodzeniem.

- AI to świetny partner dla twórców – to jest argument m.in. słynnego Dona Normana, z którym wdałem się w dyskusję na LinkedIn – przedstawiam ją na końcu niniejszego tekstu.

- To jest duża oszczędność czasu i pieniędzy.

- Nikt rozsądny nie ściga się w obliczeniach z kalkulatorem.

- Wszystko z czasem ulega automatyzacji, więc czas na branżę kreatywną.

- „Zasoby ludzkie” można „przesunąć” do innych zadań.

Część z tych argumentów opiera się na fałszywych analogiach (ang. false analogy logical fallacy), jest to jednak temat na osobny wpis. Część natomiast jest słuszna, gdy za punkt wyjścia uznamy logikę postępu technicznego rozumianego w kategoriach zwiększania efektywności pracy. Przyjmując takie założenie, z pola widzenia znikają nam inne logiki, które mogą powiedzieć więcej o tym, co możemy stracić jako jednostki oraz cała cywilizacja.

Wielki krok do przodu, czy do tyłu?

Długofalowe skutki popularyzacji generatorów obrazów text-to-image będą mogły zostać ocenione retrospektywnie dopiero za jakiś czas. Być może myśliciele w przyszłym stuleciu uznają to za ważny i potrzebny wynalazek. Ja jednak odejdę od longetermistycznej (wybaczcie mi tę kalkę) nadziei, że w długiej perspektywie czasowej wyjdzie to wszystko ludzkości na dobre i przyjrzę się konsekwencjom w krótkiej oraz w średniej perspektywie. Całość moich rozważań oprę na obowiązującym w świecie bogatej północy modelu społecznym i ekonomicznym, który ma olbrzymi wpływ na funkcjonowanie biednego południa. Nie będę w tej chwili rozważać innych modeli funkcjonowania społeczeństwa (tych obowiązujących i teoretycznych).

Omawiane zjawisko jest bardzo świeże i nie dysponuję badaniami, które mogłyby wzbogacić i ugruntować moją argumentację. Jako teoretyzujący praktyk projektowania spekulatywnego pozwolę sobie wypisać kilka punktów do rozważenia, które przyszły mi do głowy.

- Negatywny wpływ na rozwój jednostki – wiele rozwiązań cyfrowych tylko pozoruje rozwój umiejętności, a de facto powoduje ich ograniczanie, co przekłada się na realne zmiany w mózgu jak i zaburzenia codziennego funkcjonowania. Powszechnie znanym przykładem jest zaburzenie koncentracji i skorelowane z nim zwężenie rozpiętości uwagi. Procesy twórcze, to wspaniały trening koncentracji, które wspierają rozwój poznawczy ludzi w każdym wieku. Wyprzedzając niektóre głosy napiszę, że nie każdy będzie mógł pozwolić sobie na hobby w postaci samodzielnego rysowania, nie tylko ze względów ekonomicznych, ale z powodu braku wytworzenia odpowiednich struktur w dzieciństwie i wczesnej młodości (o wpływie generatywnych AI na edukację napiszę jednak osobny tekst, w którym postaram się rozwinąć ten wątek).

- Zwiększenie produktywności firm i wybranych sektorów gospodarki, kosztem miejsc pracy – niezaprzeczalnym jest, że systemy sztucznej inteligencji zwiększają efektywność wybranych procesów tych organizacji, które je wdrażają, więc artyści pracujący w sektorach, w których głównymi czynnikami są ilość i szybkość, będą musieli się przystosować, aby przetrwać, w innym wypadku stracą pracę. Stanowiska związane z pracą z użyciem maszyn będą istnieć, ale nie będą trwałe i nie będzie ich wiele.

- Utrata pracy, a wraz z nią poczucia wartości i sensu – jest to zjawisko, z którym mierzy się wiele osób pozbawionych pracy. Argumentacja Davida Graebe’a dotycząca pracy bez sensu, tylko częściowo do mnie trafia. Praca w naszej kulturze jest fundamentem poczucia godności. Możemy jej nie lubić, ale nadaje nam ramy w życiu i buduje poczucie sprawczości i wewnątrzsterowności. Automatyzacja kolejnej gałęzi gospodarki, tym razem tej kreatywnej, to zasilenie armii bezrobotnych, którzy na nowo będą musieli się odnaleźć, a także ich osobisty i rodzinny dramat. Proszę mi tylko nie zarzucać, że staję w obronie zawodów kreatywnych, a nie przejmuję się automatyzacją w innych gałęziach gospodarki – to nie prawda. Poruszam te tematy od ponad dekady – odsyłam wszystkich zainteresowanych do moich wykładów z WUD Silesia, czy UX Poland.

- Wpływ na kulturę – zastanawiam się, jak duży wpływ na kulturę będzie miała popularność obrazów, które będą generowane w oparciu o olbrzymia bazę danych. Czy będzie to źródło nowej twórczości, czy odtwarzania w koło tego samego?

- Spuścizna po naszych czasach – co pozostawimy po sobie kolejnym pokoleniom – czy będziemy mieli wspaniałych artystów i ich dzieła, czy wystarczą nam AI arty?

- „Inflacja contentu” – myślę, że nie zaskoczę nikogo przewidywaniem, że możemy spodziewać się spadku wyceny za sztukę cyfrową, wraz ze wzrostem podaży wygenerowanych przez AI obrazków. Jeżeli każdy może generować obrazy w ciągu kilku sekund za pomocą kilku słów, to szybkie nasycenia rynku i hiperinflacja cyfrowych treści są nieuniknione. Być może będzie to szansa dla twórców pracujących poza sferą cyfrową, ale kogo będzie stać na ich prace przy rosnącej asymetrii w dystrybucji kapitału?

- Odnajdywanie jakości w procesie twórczym – proces twórczy to istotny element życia twórców, ale też osób, które sztukę potrafią docenić. Być może świat pójdzie w kierunku doceniania artystów, którzy wraz z przygotowanym obrazem będą dostarczali „proof of process”. Być może rodzi się tutaj przestrzeń na zastosowanie NFT do ochrony praw autorskich twórców?

- Egzystencjalne pytanie dla uczelni i szkół plastycznych dotyczące przyszłości kształcenia w obszarze malarstwa, czy ilustracji – czy szkoły artystyczne będą jeszcze potrzebne? Jak się zmienią? Może będą bardziej nastawione na działalność społeczną i rozwiązywanie problemów? Czy będą jeszcze chętne i chętni na studia artystyczne?

- Akceleracja dezinformacji i treści, które nigdy nie powinny powstać – jeżeli można wygenerować dowolny obraz dzięki generatorom text-to-image, to mogą powstawać też treści skandalizujące, fałszujące rzeczywistość, czy niezgodne z prawem. Część generatorów to rozwiązania Open Source, które można uruchomić bez konieczności podłączania ich do Internetu, więc w łatwy sposób będzie można wyłączyć filtry zabezpieczające możliwość generowania nieodpowiednich treści, co stworzy nowe kategorie problemów prawnych, moralnych, czy związanych z rzetelnością przekazu dziennikarskiego.

- Nieznane niewiadome – pojawi się szereg nowych zjawisk społecznych i problemów, które będą niezamierzonymi konsekwencjami rozwoju i popularyzacji tej technologii, wynikającymi ze splecenia jej skutków z innymi obszarami problemowymi, technologiami, ludźmi. To wynika ze złożoności systemów, w których funkcjonujemy i przyległych do nich ewentualności (ang. adjacent possibilities).

To nie jest lista zamknięta i pewnie z każdym dniem będę mógł dopisywać do niej kolejne punkty.

Antropomorfizacja jako przykrywka do unikania odpowiedzialności

Badania opublikowane na łamach iScience w sierpniu 2020 roku pt. „Who Gets Credit for AI-Generated Art?” wykazały, że w zależności od tego, czy nadajemy systemom AI cechy ludzkie (antropomorfizacja), czy traktujemy je jako narzędzia cyfrowe (z czym się nie zgadzam, bo uważam, że mówienie o systemach złożonych jakimi są produkty takie jak ChatGPT czy Midjourney, w kategoriach narzędzi, wprowadza istotny błąd w percepcji tychże systemów – ale o tym za moment), to inaczej przypisujemy autorstwo i odpowiedzialność w sprawach związanych ze sztuką generowaną przez AI.

Dużo łatwiej jest uznać wygenerowane obrazy za magiczne wręcz artefakty, które powstały dzięki SZTUCZNEJ INTELIGENCJI i naszym genialnie przemyślanym promptom, a ciężej jest spojrzeć na AI, jako na bardzo złożony system składający się zarówno z algorytmów, sieci neuronowych, wielkich zbiorów danych, infrastruktury technicznej konsumującej olbrzymie ilości energii oraz szerokiego grona ludzkich interesariuszy. Wśród nich są m.in.:

- właściciele danego rozwiązania (np. firmy OpenAI, Midjourny Inc. Stable AI), którzy mają swoje interesy, poglądy i przekonania,

- programiści, inżynierowie i naukowcy, którzy pracują nad rozwojem modeli, sieci neuronowych i algorytmów, którzy mają swoje poglądy i przekonania i przenoszą je na opracowywane rozwiązania,

- osoby projektujące interfejsy komunikacji człowieka z programem,

- marketingowcy, którzy na zlecenie tych firm robią bardzo dużo szumu i PRu wokół ich produktów,

- prawnicy, którzy dwoją się i troją, aby wymyślać takie licencje i regulaminy, żeby minimalizować ryzyko np. związane z wzięciem odpowiedzialności za łamanie praw autorskich, czy zabezpieczyć własność intelektualną firm,

- zespoły ds. etyki – przynajmniej część firm chwali się, że podejmuje działania aby AI „była etyczna”, co jest ciekawym tematem na osobny wpis,

- zespoły ds. bezpieczeństwa – szukające luk w oprogramowaniu, jak i mitygujące ryzyko „niewłaściwego” wykorzystania oprogramowania,

- inwestorzy, którzy obecnie wkładają miliardy dolarów w rozwój firm tworzących AI, licząc na olbrzymie zyski w przyszłości,

- trenerzy sztucznej inteligencji, którzy opisują dane i oceniają jak dobrze sieci neuronowe radzą sobie z postawionymi przed nimi problemami,

- kuratorzy i moderatorzy treści, którzy oceniają czy powstające w wyniku działania modeli obrazy są prawidłowe i czy nie wymagają cenzury,

- osoby, które w większości są nieświadome, że udostępnione przez nie zdjęcia w Internecie pozwoliły wytrenować generatywne modele – na tej stronie możecie sprawdzić, czy w 5 miliardach obrazów znajdują się również Wasze fotografie i obrazy, które roboty indeksujące mogły zeskrobać z otwartych zasobów Internetu, a firmy trenujące na nich swoje modele, nie widziały potrzeby, aby kogokolwiek zapytać o zgodę,

- użytkownicy, którzy wpisują prompt i w odpowiedzi dostają wygenerowany obrazek – często będąc przy tym przekonanymi, że obrazek magicznie powstał dzięki sprawczej i świadomej AI, która mieszka po drugiej stronie monitora; (chociaż część z nich powie, że skorzystała tylko z „narzędzia”, co też jest błędnym przekonaniem),

- i wielu, wielu innych.

Nie jest to takie proste, aby w sposób jednoznaczny określić autorstwo obrazu, ale na pewno wygodnie jest zasłonić całą złożoność systemów budowanych przez prywatne firmy, które sprzedają swoje rozwiązania w formie generatorów text-to-image, narracją na temat sztucznej inteligencji (której często przypisujemy ludzkie cechy, bo w ten sposób szukamy spójności w wytworach programu – „bo program zrozumiał, co chcieliśmy”).

Generowanie obrazków jest jednak tylko jedną z funkcji firm stojących za tymi rozwiązaniami. Innymi funkcjami są np. zarabianie pieniędzy, budowanie sieci wpływu, przejmowanie dominacji w ramach danego sektora.

Przejmowanie sztuki cyfrowej

Jeżeli jakaś firma, w którą inwestowane są miliardy dolarów, powtarza ciągle, że robi coś dla dobra całej ludzkości, to mam przeczucie, że w pierwszej kolejności robi dobrze sobie.

Można uznać, że wprowadzenie rozwiązań opartych o sztuczną inteligencję, to przeróżne benefity dla ludzkości, w tym skuteczne rozwiązania diagnostyczne w medycynie, rozwiązania optymalizacyjne „uwalniające ludziom czas, od robienia rzeczy powtarzalnych” (temat na osobny wpis), czy też rozwiązania pozwalające podejmować „lepsze decyzje” (to też temat na osobny wpis). Jednak wraz z popularyzacją takich rozwiązań tworzy się coraz większa dysproporcja w zyskach, ponieważ firma technologiczna posiadająca rozwiązanie, może je skalować, bez konieczności zwiększania zatrudnienia, a samo rozwiązanie będzie wpływało na zmniejszenie zapotrzebowania na rynku pracy na specjalistów, którzy ze względu na dane rozwiązanie pracę stracą.

Oczywiście wokół tej firmy powstaną nowe działalności, które będą czerpały zyski w oparciu o udostępniane rozwiązania, jednak gro zysków będzie szło do firmy, która dominuje w danym momencie na rynku. Takim przykładem może być Youtube, na którym popularni influencerzy zarabiają dużo pieniędzy, jednak jest to niewspółmierne z zyskami platformy Youtube, podczas gdy większość twórców zarabia grosze, albo nie zarabia wcale. Podobnie jest w przypadku zysku z reklam Google, czy tych na platformach Facebook, Instagram, Tik-Tok, nie mówiąc już o tym, ile naszych danych przekazujemy tym firmom, za możliwość „bezpłatnego” korzystania z oferowanych przez nie usług.

Asymetria w przychodach to nie wszystko. Jest to również asymetria we władzy nad konkretnymi działalnościami, ale i całymi sektorami usług. Jeżeli platforma społecznościowa może z dnia na dzień usunąć czyjś profil, a kanał Youtube może zostać zablokowany, to stanowi olbrzymie ryzyko dla prowadzenia działalności na tych platformach. Jednocześnie przez ich dominującą pozycję ciężko jest działać poza nimi.

I teraz wyobraźmy sobie, że kilka firm zlokalizowanych w Dolinie Krzemowej i Shenzhen może posiadać asymetryczną władzę nad generowaniem obrazów i trzymać rękę na tym, jakie obrazy będą mogły powstać, jak będzie tworzona sztuka, kto będzie ją tworzył, ile warta będzie praca twórców i czy będą oni potrafili odnaleźć sens w nauce i rozwoju, bo nowe systemy cyfrowe uczynią ich fach przeżytkiem. Czy dziesiątki tysięcy lat twórczej energii, którą ludzie w każdej kulturze rozwijali tworząc sztukę, mamy ograniczyć do zachwytów nad syntetycznie generowanymi obrazami przez robota Botto, i milionów użytkowników Internetu, którzy wpisują w Midjourney i DALL-E2 pojedyncze słowa, aby uzyskać coś trochę jakby Beksińskiego, Moneta, Van Gogha, tylko że z pieskami i logo Macdonalda?

Właśnie na naszych oczach dokonywane jest przejęcie sektora kreatywnego w dziedzinie statycznego obrazu, a powoli też i filmu oraz dźwięku, w rytm narracji o tym, że teraz każdy będzie mógł być artystą i będzie to rozkwit kreatywności dla wszystkich. Obawiam się, że nie będzie, chociaż uwierzcie mi, tak bardzo chciałbym się mylić.

Zastanawiam się, jak wygląda w tej chwili debata na ten temat na polskich uczelniach artystycznych i w szkołach plastycznych. Jakie kroki podejmują władze uczelni, pracownicy, środowisko akademickie, studentki i studenci? Jeżeli dzieje się coś w tym temacie, to bardzo proszę o informacje, bo do tej pory nie znalazłem żadnych informacji w tej sprawie.

Zalecam ostrożność

AI generująca obrazy to nie inteligentna i sprawcza maszyna, tylko złożony system osób pełniących różne role, algorytmów, własności intelektualnej, infrastruktury i inwestowanych w doń niemożliwie wielkich pieniędzy. To też nasze dane – zdjęcia i obrazy twórców wykorzystywane bez zgody. To pytania o przyszłość sztuki, kultury i nas samych.

Uważam, że w krótkiej perspektywie czasowej cały temat generatorów text-to-image może być lekceważony, traktowany jako hype i gadget, ale w średniej i długiej perspektywie będzie to poważny problem.

Jestem daleki od oceniania osób, które odnalazły radość, możliwość wyrażania się, czy nawet zarabiania, dzięki wymyślaniu promptów dla generatorów text-to-image. Każdy korzysta jak może, aby poprawić swój byt w świecie, w którym zwycięzcy biorą większość.

Boję się jednak, że właśnie rozpoczęła się redukcja ludzkiej twórczości do umiejętnego definiowania i wpisywania promptów do prywatnie zarządzanych modeli generatywnych, a to nie wróży nic dobrego. Mleko w pewnym sensie już się rozlało i ograniczenia prawne mogą pewne procesy opóźnić i wprowadzić jakiś porządek. Nie widzę jednak możliwości cofnięcia tej „innowacji” i wszyscy będziemy musieli ponieść jej koszt, niezależnie od indywidualnego stosunku do oferowanych korzyści.

Nie jestem głosem całej branży projektowej czy artystycznej. Piszę za siebie, piszę o swoich obawach. Wierzę jednak, że jest to bliskie również innym, że istnieje duża grupa ludzi, którzy nie uważają, że adopcja narzuconych przez „rynek” rozwiązań, to „pójście z duchem czasu”. W historii znamy wiele innowacji, które przyczyniły się do poprawy jakości życia, ale też wielokrotnie ludzkość była w błędzie i robiła rzeczy, z których ciężko było się wycofać.

Ps

Wiem, że ten tekst nie był łatwy, w szczególności dla osób, które wiążą swoje obecne i przyszłe życie ze sztuką – ilustrują książki, tworzą grafiki na zamówienie, przygotowują concept arty do gier i filmów. Chcę Wam życzyć, aby satysfakcja i radość z rozwijania Waszej pasji do projektowania i tworzenia sztuki nigdy nie wygasły. Żaden algorytm, sieć neuronowa i sztuczna inteligencja, nie odbiorą Wam Waszego wyczucia, intuicji i jakości, którą odnajdujecie w twórczym procesie. Mimo, że wkoło powtarzane jest jak mantra, że to AI jest przyszłością, ja mocno wierzę, że przyszłością są ludzie twórczy, którzy idą za swoim wewnętrznym głosem i dzielą się ze światem swoją wrażliwością – czymś, czego nie da nam żaden, nawet najbardziej niesamowity algorytm.

*sztuka nieludzi

We wstępnie napisałem, że wyrażanie się poprzez sztukę, to bardzo ludzka rzecz. Chcę zaznaczyć, że ze względu na poruszany w tekście problem posłużyłem się antropologiczną definicją sztuki, z której wykluczone są zwierzęta. Uważam, nie tylko z powodu bycia opiekunem Nutki, czy współtwórcą „Rzeczywistości ewentualnej„, że zwierzęta są bardzo twórcze. Nie chciałem jednak w tym tekście przykładać ludzkich miar do istot nie będących ludźmi i odbiegać od głównego tematu.

Na koniec bonus dla wytrwałych. Mimo sympatii, jaką darzę Dona Normana i uznając jego dokonania, nie potrafiłem zgodzić się z nim w promowaniu generatorów AI artów i stawiania ich jako rozwiązań partnerskich dla twórców. Don na Linkedin promował swój kurs realizowany przez Interaction Design Foundation (IxDF), które jak widać próbuje zarobić 50$ na każdym, kto w tej chwili czuje na swoich plecach oddech zmiany lub szansę na lepszy byt. Pytanie, czy taka organizacja jak IxDF nie powinna wziąć udziału w szerszej debacie na temat rozwiązań generatywnych, zamiast tworzyć entuzjastyczne kursy?